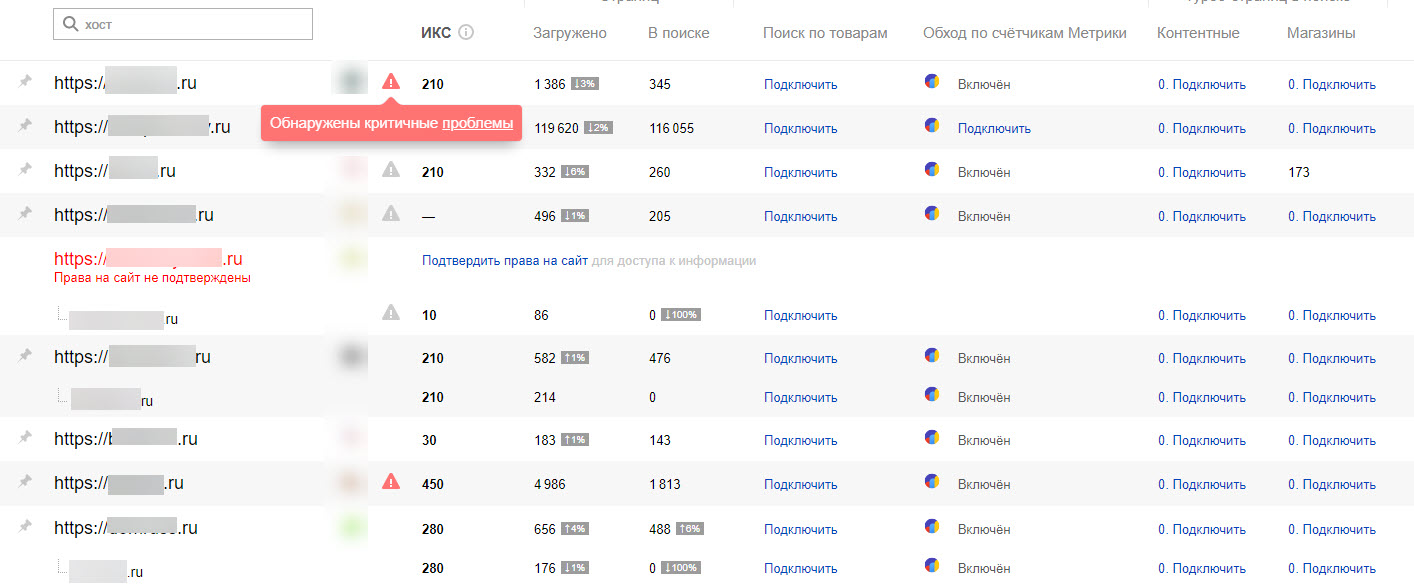

Добрый день уважаемые читатели блога pyatilistnik.info, открываю я сегодня веб кабинет Яндекса и обнаруживаю на против двух своих сайтов, восклицательный знак, зайдя в первый сайт я увидел фатальную ошибку с вот таким содержимым: «Сайт может угрожать безопасности пользователя, или на нём были обнаружены нарушения правил поисковой системы. Наличие этой проблемы негативно сказывается на положении сайта в результатах поиска.» Давайте смотреть в чем причина и каким образом вы сможете это исправить.

Более детальный вид ошибки «Сайт может угрожать безопасности пользователя»

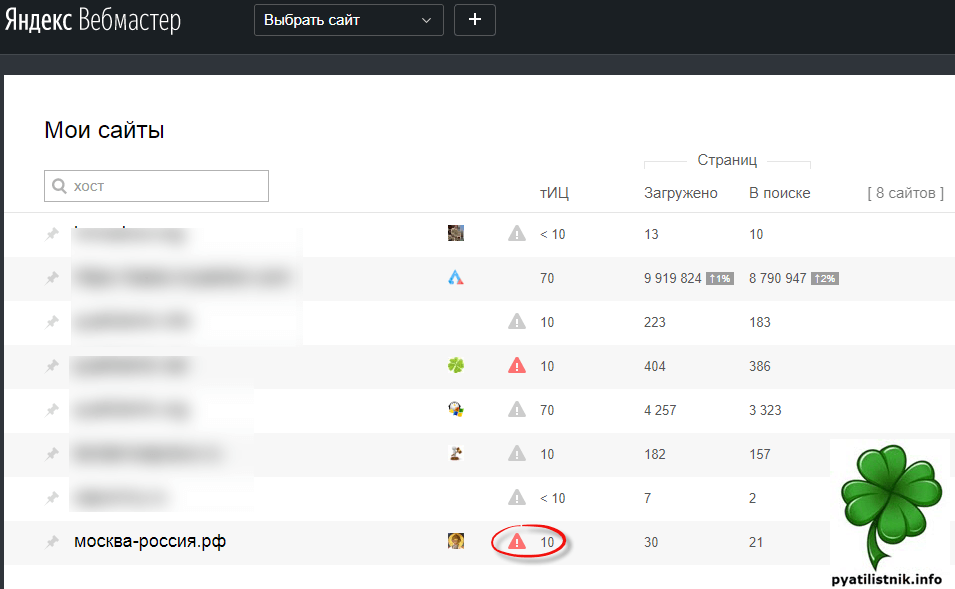

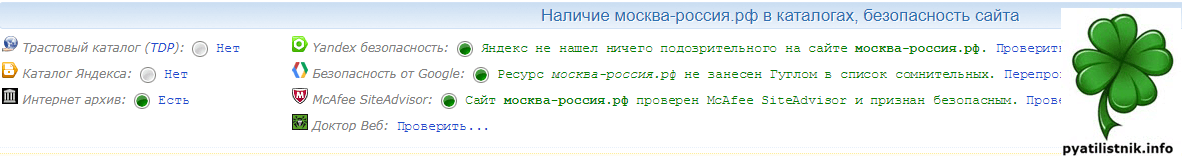

И так есть пациент, мой один из блогов (http://москва-россия.рф/) на нем я делюсь своим опытом проживания в Москве, где и куда там пойти и что и где посмотреть, если вы его еще не видели, то милости прошу. Захожу я в webmaster кабинет и вижу как и писал выше, предупреждение.

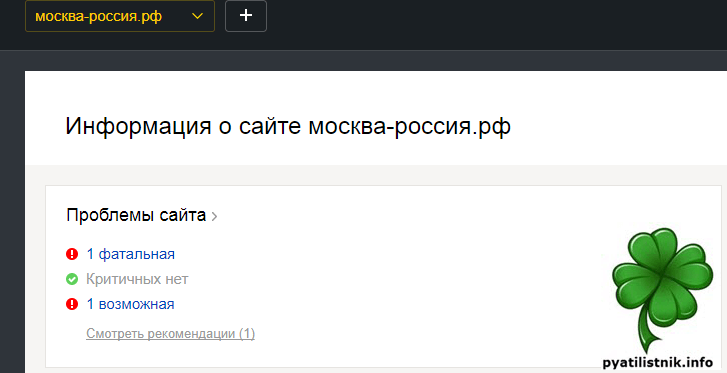

Зайдя в настройки самого сайта, я увидел следующую картину: 1 фатальная ошибка, щелкаем по ней, чтобы посмотреть детали.

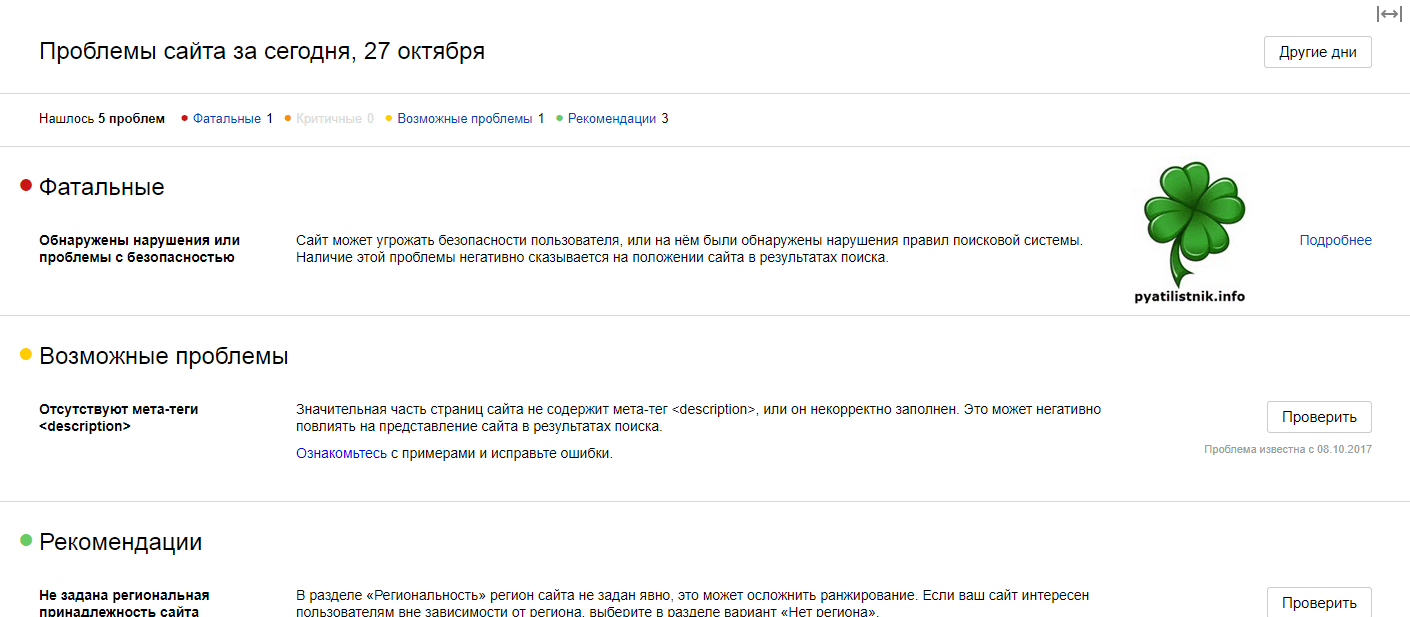

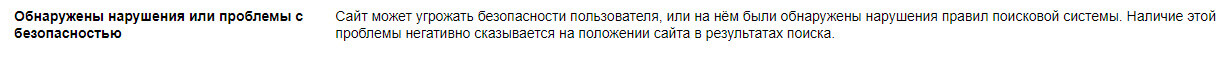

В итоге видим, что обнаружены нарушения или проблемы с безопасностью, сайт может угрожать безопасности пользователя, или на нём были обнаружены нарушения правил поисковой системы. Наличие этой проблемы негативно сказывается на положении сайта в результатах поиска

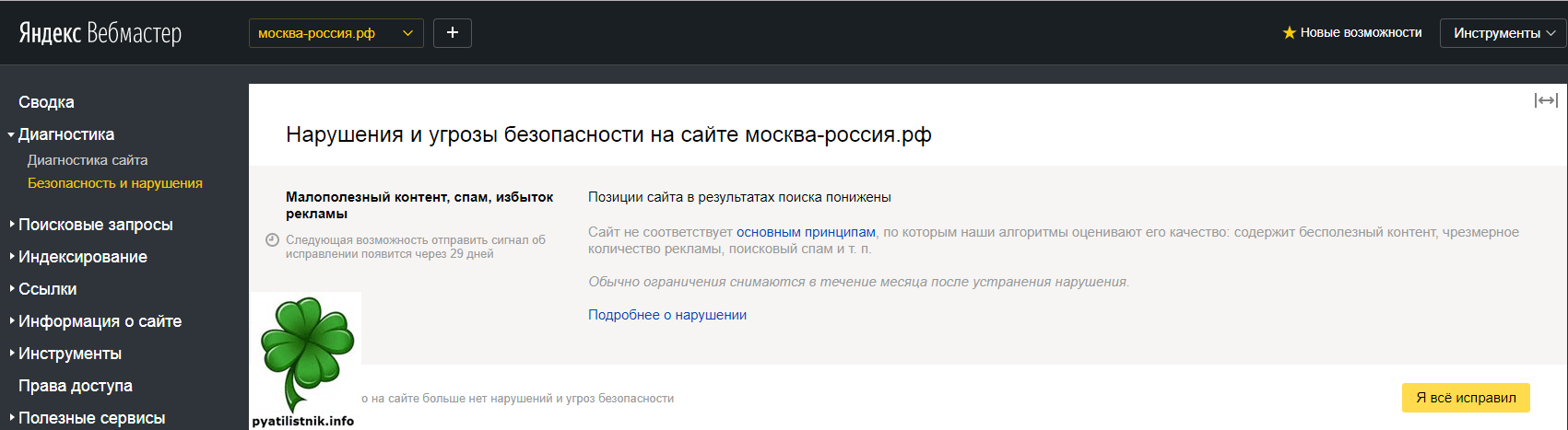

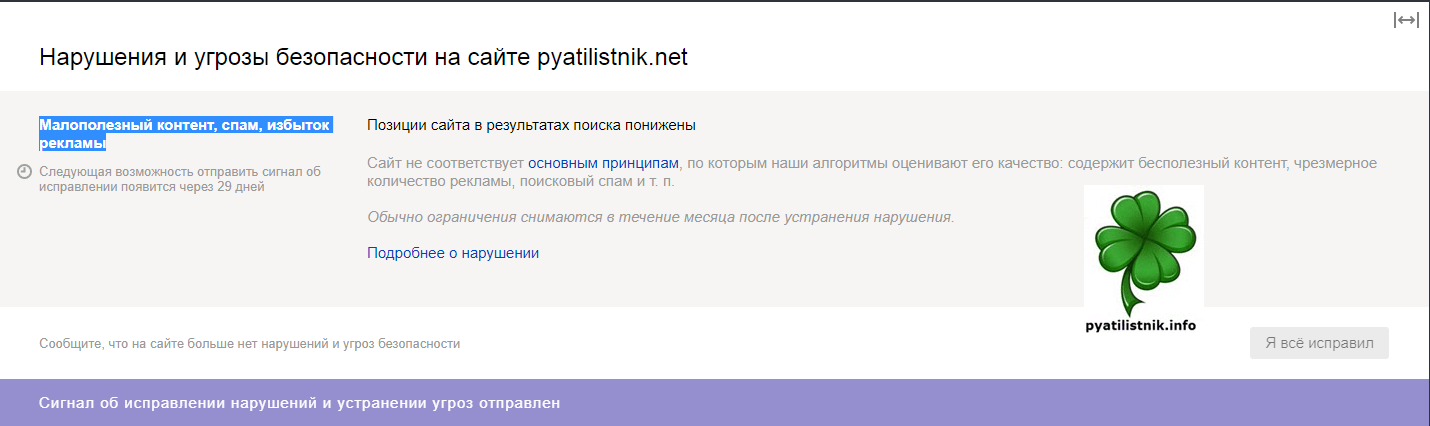

Справа есть ссылка «Подробнее». Тут вы уже детальнее видите, что по мнению Яндекса, его не устраивает в вашем ресурсе. В моем случае у меня «Малополезный контент, спам, избыток рекламы» и обратите внимание есть кнопка «Я все исправил» это в духе поисковой системы, не знаю за что вы там словили предупреждение, вам типа лучше знать, но как исправите нажмите кнопку.

Что делать в такой ситуации?

- Убедитесь, что у вас уникальный и полезный контент, если вы его писали сами, то это хорошо, но нужно проверить его, ниже я покажу как

- Убедитесь, что ваш сайт не подломали и не залили туда вредоносный код

- Убедитесь, чтобы у вас не было продажных ссылок на сайте

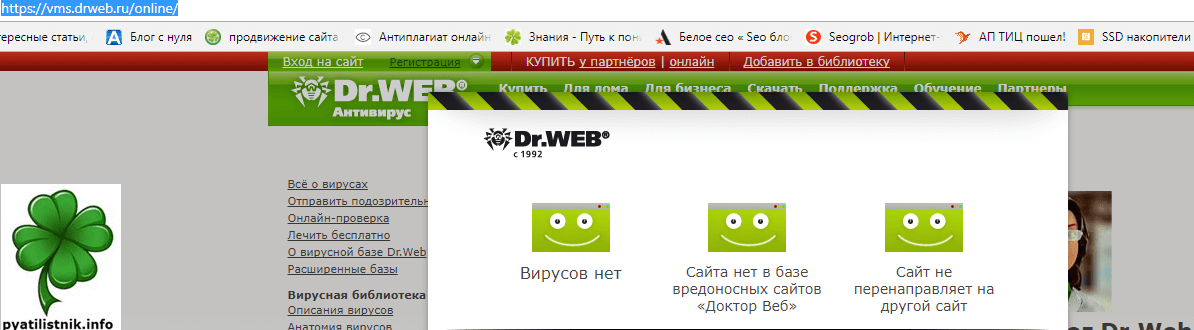

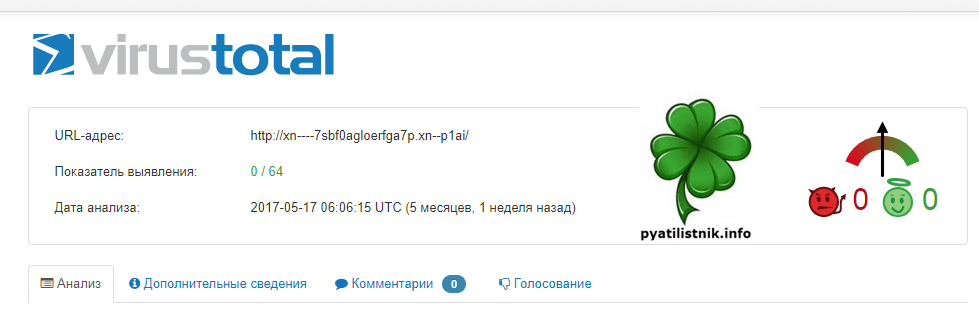

Проверка сайта на вирусы

Первое, что я вам советую сделать это просканировать ваш сайт на вирусы. Ниже список ресурсов, которые вам в этом помогут.

- http://www.sbup.com/audit/

- https://vms.drweb.ru/online/

- https://www.virustotal.com/ru/url/

- https://sitecheck.sucuri.net/

Как видите, каждый из ресурсов показал, что с безопасностью сайта и зараженностью, его вирусами, все в порядке, и этот пункт претензий можно отметать. Если же сканеры, что либо обнаружили, то вам необходимо найти вредоносный код и удалить его, для этого вам советую воспользоваться инструментом «Айболит».

Снять продажные ссылки

Если вы любитель приторговывать ссылками, то вы легко попадете под фильтры Яндекса. Советую их снять и начать играть по честному.

Проверка текстов

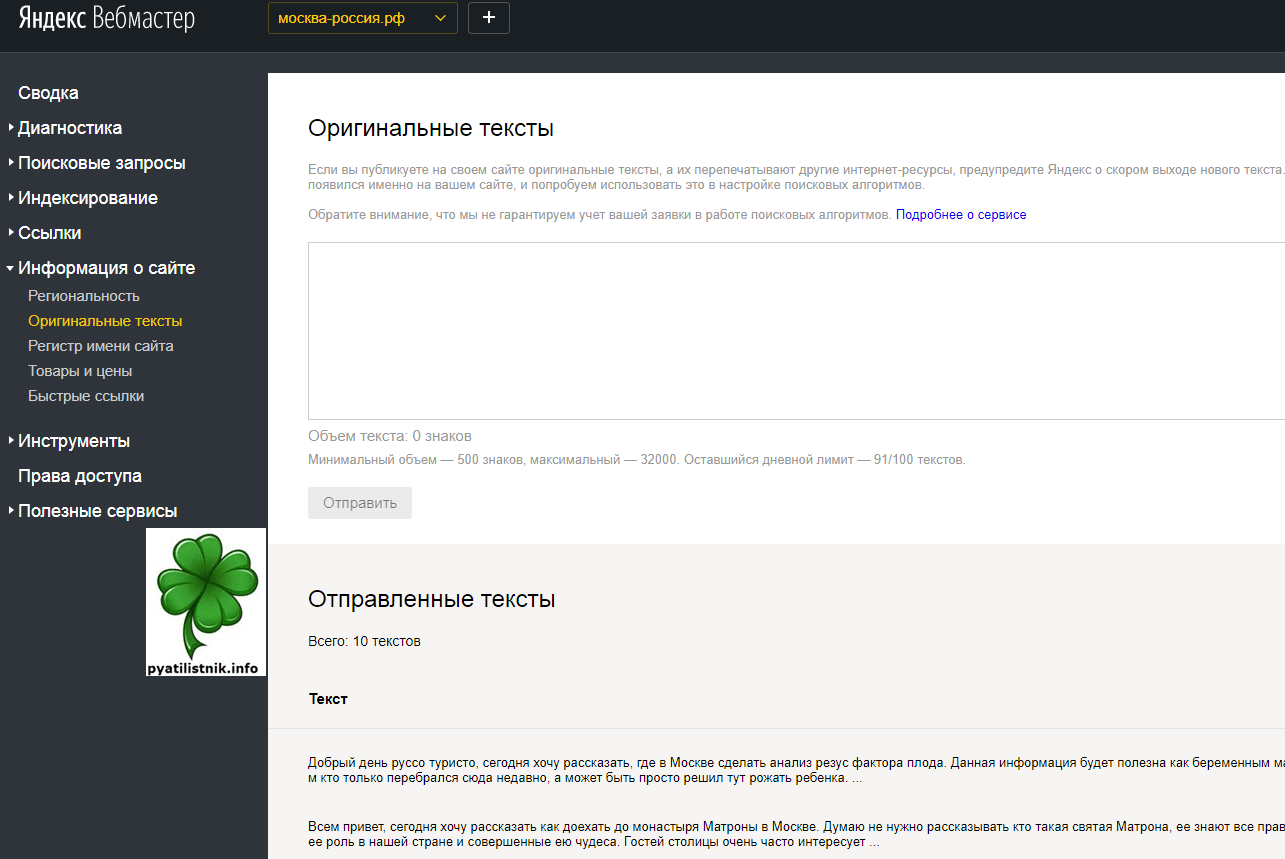

Во первых я вам советую, как только вы написали новую статью, перед ее публикацией, добавьте ее текст в «Оригинальные тексты» в вебмастере. Это покажет Яндексу, что вы первоисточник текста.

Далее с помощью сервиса http://www.content-watch.ru/text/, советую вам проверить, нет ли вашего текста на других сайтах. Сервис легко найдет, любителей тырить ваш контент, после проверки вы получите ссылки на эти страницы.

Уменьшение рекламы

Я попал именно под эту причину, у меня было в текстах по 6 рекламных объявлений и естественно не Яндекс директа. Сняв 3 из них, меня в итоге реабилитировали.

Как только вы все исправили, то жмите кнопку

Еще полезные моменты

В самом низу кабинете webmaster есть ссылка на обратную связь, где есть возможность создать тикет (обращение) в техническую поддержку поисковой системы, советую параллельно ей воспользоваться, быстрее может все решиться.

Так же советую воспользоваться веб архивом (http://web.archive.org/) и проверить не было ли левых сайтов ранее по вашему адресу, возможно прилетела зараза, из-за старой истории.

Надеюсь вам удалось очистить ваш сайт в глазах Яндекса и вы восстановили свою репутацию, позиции и доход, и возможно стоимость сайта.

Сегодня коснёмся ошибок сайта в вебмастере Яндекса, которые он последнее время щедро раздаёт администраторам площадок: тема весьма обширна и бесконечна в плане разговоров, ибо нет никаких существенных пояснений от, скажем так, законодателей ПС Яндекс, а значит — предполагать можно бесконечно.

Ниже рассмотрим примеры подсказок в вебмастере о фатальных ошибках: когда, мол…

…по мнению алгоритма пс Яндекс, наш сайт угрожает безопасности пользователей… или практически прямое обвинение администрации сайта в спаме, бесполезности ресурса (его контента) для соискателей в интернете и пр. и пр. о чём весьма расплывчато говорят сообщения в инструментарии Яндекса.

Занавес открывается:

вебмастер поисковой системы Яндекс — ошибки сайта

-

или веб мастер Яндекс прав, указывая на ошибки?

-

закрываем от индексации странички с не уникальным контентом

(мне пришло в течение недели несколько писем, в которых коллеги-новички просили разъяснить (личную) ситуацию в веб мастере Яндекс.

Должен к своей величайшей радости доложить, что и на одном из моих подопечных сайтов наблюдается описанная проблема. Сайт достаточно новый, администрация пока что относит себя к разряду новичков, а посему я и помогаю иногда…

Так вот, чтоб не говорить много раз одно и то же, решил написать такой коротенький пост размышление…

Однажды мы заходим в святая святых вебмастера и наблюдаем следующую картину: (к слову, это предупреждение относится Яндексом к фатальным ошибкам)

Если кликнуть по восклицательному значку, то нас перебросит на страничку с более подробными описаниями проблемы и пр.

Впрочем, вот симпатичные фразеологизмы, сформулированные «веб мастером Я. в помощь «наказанному владельцу сайта»:

Сайт может угрожать безопасности пользователя, или на нём были обнаружены нарушения правил поисковой системы. Наличие этой проблемы негативно сказывается на положении сайта в результатах поиска.

Позиции сайта в результатах поиска понижены

Сайт не соответствует основным принципам (ссылка подсказки //yandex.ru/support/webmaster/yandex-indexing/webmaster-advice.xml), по которым наши алгоритмы оценивают его качество: содержит бесполезный контент, чрезмерное количество рекламы, поисковый спам и т. п.

Обычно ограничения снимаются в течение месяца после устранения нарушения.

//yandex.ru/support/webmaster-troubleshooting/lowqualitysite.xml

И ещё одно пояснение владельцу сайта, в котором говорится, что на всё про всё (т.е на исправление вебмастером ошибок, и переиндексацию сайта роботом) дан месяц до следующего нажатия на кнопку.

Следующая возможность отправить сигнал об исправлении появится через 29 дней

Что получается? …если мы, скажем, исправили свои ошибки, которые, к слову сказать, многим владельцам не ясны, у нас есть возможность отправить запрос на перерассмотрение нашего сайта на ошибки.

В течение месяца, ПС обещается разрешить проблему и устранить предупреждения!! если ошибки устранены.

Мне подумалось вот о чём: (конечно же, это сугубо личное мнение)

Картина такова: есть сайт. На сайте обнаружены грубые ошибки (которые констатируются Я. как фатальные — в русском языке, это понятие попросту значит — кирдык)). А слово «кирдык» все знают что такое — конец! Естественно, начинающий админ горько переживает! А, главное, не знает как решить эти задачи ошибок: с чем я вынужден согласиться — подобные пояснения, крайнее свинство со стороны ПС.

Я не знаю! кто составлял такие пояснения. На мой взгляд, должны быть хотя бы более менее ясные указания на ошибки. Далее…

Особенно забавляет вот что: предположим, сайт кем-то изначально создавался как ГС! — для продажи ссылок, спама и прочей фигни… Авторы сего сайта это прекрасно понимают и им откровенно по болту все эти предупреждения в вебмастере.

Но вот когда такие ласковые напоминания об ошибках приходят добропорядочному новичку (и пусть он не всё ещё понимает в веб разработках… путь совершает какие-то ошибки: он ведь на то и новичок) — тогда подобные предупреждения звучат как-то не по-человечески!

Владелец сайта очень переживает… нервничает… а некоторые (есть и такие) в итоге бросают ведение блогов/сайтов…

Хочется задать сакраментальный вопрос: с кем останется ПС?? …хотя, вопрос мой, конечно, так себе…

Ну, ладно…

Теперь, со своей стороны, заступлюсь и за поисковые системы, ибо — те всего-то машины; а этакие неосторожные по отношению к психике ближнего формулировки составляют люди:

к оглавлению

или веб мастер Яндекс прав, указывая на ошибки?

В сети интернет миллиарды сайтов… колоссальное количество!

Давайте зададимся таким вопросом: вот как, скажите, градировать… разделять машинам (ПС роботам) наши сайты на «хорошие» и «плохие»?

Правильно! весьма сложный вопрос. К тому же, мы по сути находимся пока ещё у истоков развития индустрии интернета! Что там времени-то прошло от великого начала…

Машины при всей своей «памяти» пока ещё не обладают разумом. И нам с вами, новичкам, думается, стоит это понимать.

И, как это ни прискорбно понимать новичку, порою (я бы даже сказал — зачастую) сам автор сайта виноват в наложении подобных санкций, предупреждений.

Если указки ПС типа: заспамленности, опасности для пользователей можно отнести к разряду древней софистики… то бесполезность контента имеет место быть!!

Заспамленность и, в какой-то мере, опасность видны визуально, и не требуют для выявления каких-то особых знаний… Прилежный админ может всё это запросто исправить.

…тогда как многие из владельцев сайтов ни в какую не хотят понять, что перекопирование материала к себе на сайт с чужих ресурсов (частично, или полностью) расценивается поисковиками как воровство.!.

к тому же: многие seoшники утверждают, будто б можно своровать у самого себя и получить за энто по шапке сайта: именно поэтому и закрывают от индексации всякие странички категорий или тегов от поисковиков, тем самым исключая дублирование контента.

Я лично, к этим убеждениям — дублирования самого себя в пределах домена)) — отношусь достаточно прохладно, ибо считать машины тупее себя, не этично) Но вполне допускаю, что в программах ПС присутствует алгоритм «воровства», копипасты… а в том числе повторение текстов, привязанных к домену.

Смею предположить, что именно вот к этой копипасте как раз и придираются поисковые машины (как бороться с дублями страниц, описано в статьях, пример кода и ссылки ниже).

И напоминаю, алгоритмы для ПС пишут люди!

Я видел много сайтов изнутри, и видел, как администратор пытается развить свой ресурс посредством банального перекопирования материала с чужой площадки… Я не хочу сказать, что этакие желания всегда движимы какими-то злостными побуждениями… нет! …скорее… частенько — наивностью… от халвы: т.е халявы))

Не забывайте об этом.

Следует всегда помнить о том, что поисковой робот не обладает и каплей разума! и скорее отнесёт невинное перикопирование к воровству, нежели… ну, вы понимаете…

Как эпилог:

Печатать на своём сайте можно всё, что угодно, но только тогда, когда он обретёт кое-какой вес в сети среди себе подобных… А пока наш с вами ресурс молод, всё-таки следует придерживаться определённых правил интернета в целом, пусть не всегда ясных и понятных, но это — правила, как ни крути:

1 — если копируете известный материал к себе на сайт, то:

а) предайте ему максимальную уникальность, или

б) закройте от индексации страничку с таким контентом.

…если приводите в тексте какую-то чужую объёмную цитату (ну или даже из своей какой-то опубликованной ранее статьи) от греха — закройте её в теги цитирования <blockquote>текст</blockquote>

к оглавлению

закрываем от индексации странички с не уникальным контентом

Закрыть странички от индексации просто, я об этом говорил множество раз…

подробнее описано, например, здесь (там далее по ссылкам). Или в этой статье рассказано об условных тегах (как раз на основе них и отрабатывается код ниже).

/** закроем от индексации странички или записи **/

function my_meta_catss_robots () {

if (is_category() or is_page('77') or is_single('77') )

{

echo "".'<meta name="robots" content="noindex,follow" />'."n";

} }

add_action('wp_head', 'my_meta_catss_robots');

/** закроем от индексации странички или записи **/В коде я дал примеры «закрытия рубрик» is_category, страничек сайта is_page и записей is_single — где просто (в скобках) указываете ID записи, страницы — у меня 77 …и пр…

Таким образом, после прописки показанного выше кода к себе на сервер, например, в файл функций functions.php активного шаблона, — в шапке сайта (в мета), если откроете исходный код Ctrl+U, будет автоматически сгенерирован метатег под кодовым понятием robots, а именно вот такая штука:

<meta name="robots" content="noindex,follow" />

…где noindex обозначает неиндексирование поисковым роботом контента (что нам и требуется). а follow — разрешает проход роботу по документу: робот будет видеть ссылки и переходить на полезные открытые документы: т.е страничка будет не бесполезна… в отличие от того, если её прикрыть напрочь ! типа: noindex,nofollow.

Рекомендую пользоваться именно этим способом закрытия страниц, но не банально в файле robots.txt.

А когда закрываете описанным выше способом — непременно — снимите ограничения в robots, коли таковые были прописаны!

Короче: на мой взгляд, зачастую все эти предупреждения вебмастера Яндекса и пр. — фигня! хотя, конечно, огорчают немного. И стоит немного потрудиться — всё будет здорово!

Чего я вам с великим удовольствием и желаю!

Однако !!

вот ещё что:

…думаю, вы и без меня знаете — и всё же, считаю долгом напомнить: иногда бывают ситуации, о которых и не подозреваешь!!

вроде бы всё хорошо, контент уникальный… но сайт никак не желает идти вверх к приличной посещаемости… и вдруг — бац!! — предупреждение от вебмастера Яндекса.

Настоятельно рекомендую, даже если у вас новенький домен, в течение нескольких месяцев проверять внешние ссылки (не ссылаются ли на ваш домен ресурсы спамеров: порно и пр. вредности в этом плане)) — всё это может обернуться неожиданными сюрпризами, которые очень и очень негативно скажутся на продвижении сайта: ну, хотя бы здесь тестируйте — //www.linkpad.ru/

Не ленитесь — проверяйте историю домена перед тем как запустить проект! Частенько бывает так, что всякие мошенники избавляются от своих отработанных доменов! а мы, ничегошеньки не подозревая, приобретаем…

Будьте внимательны к своему избранному адресу сайта (доменному имени) — ибо частенько бывает так, что, к примеру, Яндекс веб мастер обвиняет в заспамленности вашего ресурса. В подобных случаях оч. трудно доказать, что ты не свинья!!

Интересуйтесь подробнее жизнью своего сайта в интернете)) — ведь проще !! не доводить сайт/блог до состояния критических ошибок, нежели потом решать их!

Удачи!..

…А мне остаётся только раскланяться… и пожелать полезной работы в сети

Делитесь своими соображениями в комментариях…

На этом занавес представления опускается…

…на рампы пыль печальная ложится…

Online консультация по настройкам и созданию сайтов на WordPress

Online консультация по настройкам и созданию сайтов на WordPress

В кино: 1) настройка плагина Яндекс турбо.

2) связка данных плагина с вебмастером Яндекса.

3) настройки опции Турбо страницы в панели вебмастера…

…вопросы в комментариях — помогу, в чём дюжу…

mihalica.ru !

![]() Михаил ATs — владелец блога запросто с Вордпресс — в сети нтернет давным-давно…

Михаил ATs — владелец блога запросто с Вордпресс — в сети нтернет давным-давно…

…веб разработчик студии ATs media: помогу в создании, раскрутке, развитии и целенаправленном сопровождении твоего ресурса в сети… — заказы, вопросы… разработка…

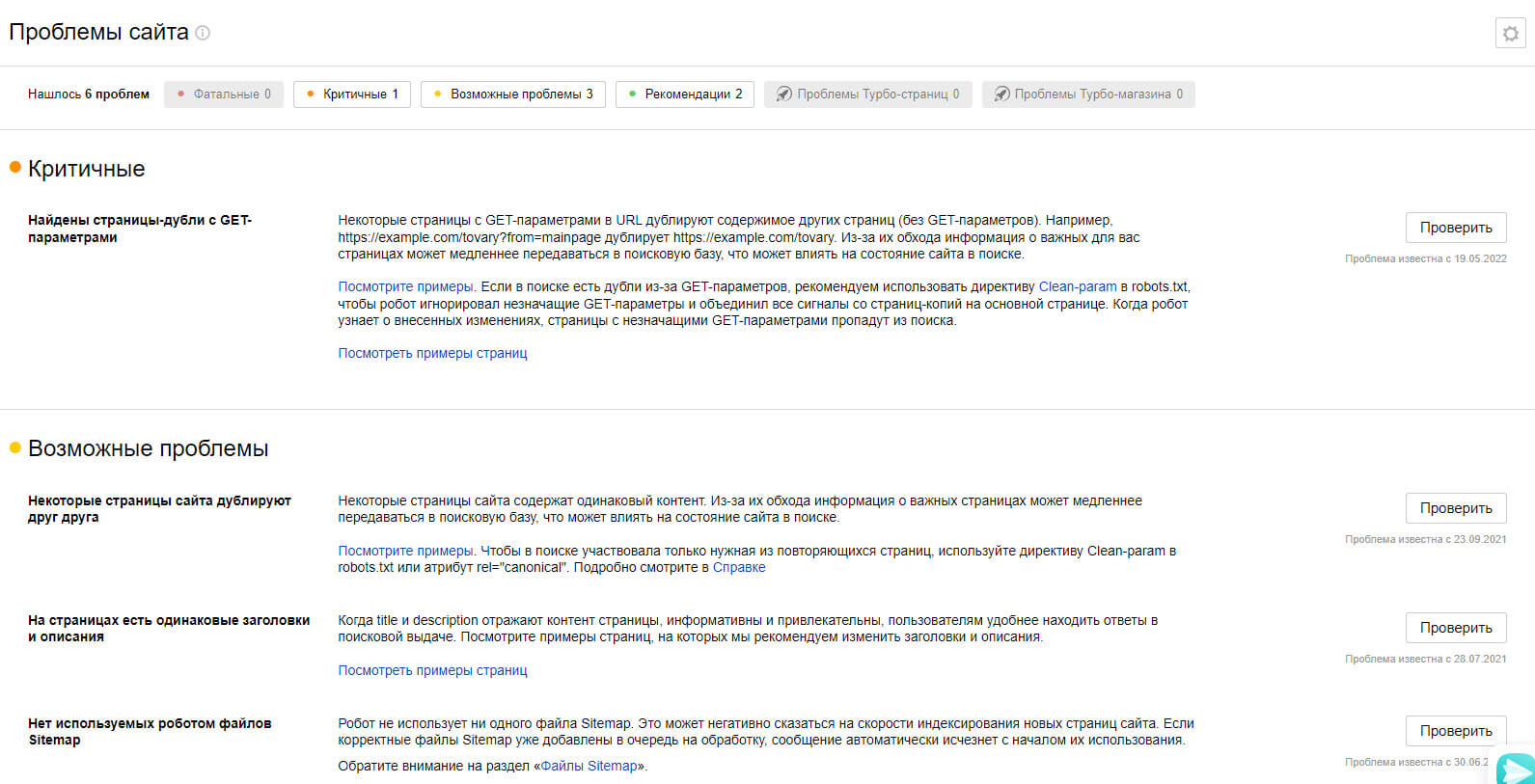

Для поискового продвижения существует много различных программ, помогающих найти ошибки сайта, влияющих на поисковую выдачу. Один из основных таких сервисов предлагает сам Яндекс. Речь идет о бесплатном инструменте для проверки оптимизации Яндекс.Вебмастере, — основном помощнике любого оптимизатора. Вебмастер Яндекса проводит анализ веб-сайта и дает пользователю полную оценку всего ресурса с точки зрения SEO. Помимо общих данных о сайте, его ссылочной массе и информации о статусе страниц, кабинет вебмастера имеет целый раздел, посвященный ошибкам, о которых сегодня и пойдет речь.

Добавляя свой сайт в панель вебмастера, необходимо подождать 4-5 дней, чтобы робот собрал всю информацию и проанализировал полностью сайт. После обновления данных о ресурсе, необходимо перейти в раздел «диагностика сайта», где владельцу сайта будут показаны все ошибки, разбитые по группам.

Фатальные ошибки

По названию категории понятно, что это наиболее важные ошибки, которые нужно исправлять максимально быстро. Наличие фатальных ошибок у сайта сразу ставит крест на его продвижение и индексации, если их быстро не удалить. Другими словами, в поисковую выдачу веб-сайт с хотя бы одной фатальной ошибкой Яндекс не пустит.

Сайт закрыт от индексации. Самая частая ошибка, возникающая после окончания разработки сайта. В файле робота (robots.txt) стоит директива не индексировать сайт. Сделано это специально, чтобы поисковик не ранжировал недоделанный сайт на техническом домене

Как исправить? Открываем файл робота, добавив после домена /robots.txt,ищем строчку «Disallow: /» и удаляем её

Серверная ошибки DNS. Чаще всего возникает при самостоятельном внесении изменений в настройке DNS в контрольной панели хостинга, или при падении серверов самого хостера.

Как исправить? Открываем сайт хостинг-цента, где хостится сайт, ищем там телефон технической поддержки и просим проверить настройки сайта, указав ошибку из панели вебмастера. Как выбрать хороший хостинг читаем тут

Ошибка главной страницы. При попытке робота он не смог загрузить главную страницу из-за временной недоступности сайта. Это может быть снова из-за хостинга, или при удалении технической папки отвечающей за загрузку на сервере.

Как исправить? Снова звоним в техническую поддержку хостинга. Если у него проблем в данный момент не наблюдается, то просим выгрузить рабочий бэкап сайта

Нарушение безопасности. При переобходе сайта, робот нашел угрозу безопасности. Это может как безобидный самописный код, являющийся с точки зрения Яндекса потенциально опасным, так и вирус.

Как исправить? Заходим на сайт Касперского (или любого другого поставщика антивирусов), скачиваем программу проверки вирусов для веб-сайтов и запускаем диагностику. При обнаружении вредоносного ПО — удаляем его.

Критические ошибки

На критические ошибки Яндекс также сразу же обращает внимание и ставит им высший приоритет наряду с фатальными. Критических ошибок всего два вида, каждая из которых может сильно пессимизировать позиции сайта в поисковой выдаче.

Внутренние битые ссылки. Гиперссылки, отдающие при переходе 404 ошибку, говорят о несуществующей текущей страницы. Возможно она была удалена, возможно поменялся чпу адрес.

Как исправить? Запускаем любой сервис по поиску битых ссылок, например «screaming frog app» и точечно исправляет url с кодом 404, или убираем гиперссылку вообще. Какие ещё бывают бытые ссылки и как исправить читаем в этой статье

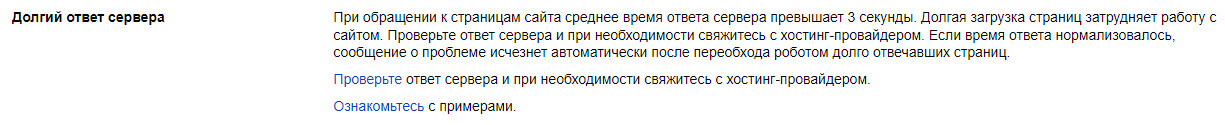

Долгий ответ сервера. На анализ сайта робот тратит определенное время, если за этот промежуток веб-сайт полностью не загрузился, то он сигнализирует об ошибке. Чаще всего это связано с внешними «тяжелыми» скриптами, установленными на страницах

Как исправить? Необходимо запустить проверку скорости через Google Pagespeed и в отчете посмотреть какие скрипты в коде сайта занимают много времени на загрузку. Оптимизировав (или удалив) их, снова запускаем проверку

Возможные проблемы

Данный раздел отвечает в основном за оптимизационные ошибки. Система может показать как ошибку по одному из параметров проверки, так и отсутствия корректной настройки, согласно общепринятому параметру соответствия сайта поисковым требованиям.

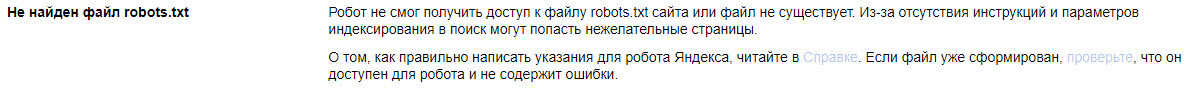

Ошибки, связанные с файлом robots.txt

-

Файла робота нет на сайте. Файла нет в корне сайта по адресу вашомен/robots.txt.

-

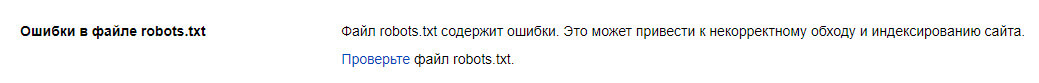

Файл робота содержит ошибки. Как правило, ошибки бывают при самостоятельном добавление этого документа. В чем именно ошибка понять сложно, так как их очень много разновидностей. От обычной опечатки в слове, до неправильного использования символа .*

Как исправить? Если файла нет, то создаем обычный блокнот-документ, заполняем его и добавляем на сайт. Если файл есть, но содержит ошибки, то очищаем его и ставим общепринятый формат:

User-agent: *

Disallow: /admin/

Host:

https://вашдомен

Sitemap:

https://вашдомен/sitemap.xml

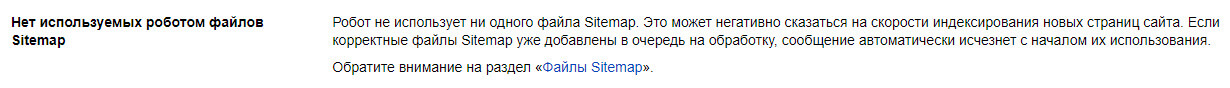

Ошибки, связанные с картой сайта sitemap.xml

-

Сайт не использует sitemap. Скорее всего динамическая карта просто не создана или её формат отличается от xml. На позиции сайта эта ошибка на прямую не повлияет, а вот на индексацию страниц может.

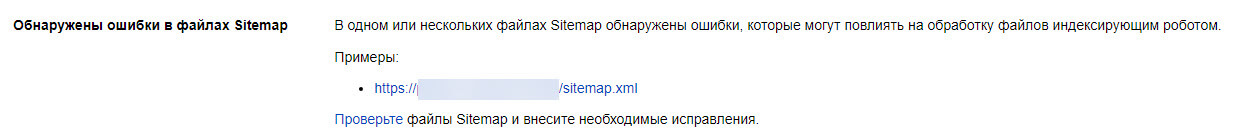

-

Имеются ошибки в файле sitemap.xml. Обычно проблема связана с несуществующими страницами, отдающими 404 ошибку. Рекомендуется проверять карту вручную, для этого в кабинете вебмастера есть соответствующий раздел

-

Карта сайта давно не обновлялась. Причина этой возможной ошибки, на сайте действительно не было обновлений контента, или sitemap перестал поддерживать автообновление.

Как исправить? Карту сайта можно автоматически создать во многих CMS. Вебмастер не всегда сразу видит карту, несмотря на то, что она корректна и есть на сайте, поэтому рекомендуется нажимать кнопку «исправлено», без внесения изменений

Ошибки оптимизации

-

Некорректно настроена страница 404 (отображение несуществующих страниц). При вводе несуществующего url, должна появиться страница сайта (со всем оформлением), показывающая 404 ошибку, с гиперссылкой на главную страницу.

-

Переадресация на другой сайт. При попытке загрузки сайта происходит перенаправление на другой домен. Это могло быть из-за ошибки редиректа, но чаще это дело вируса и вредного ПО.

-

Сайт имеет дубли в большом количестве. Дублем считается страница с идентичным контентом, отличающая только ЧПУ. Подобных «парных» страниц не должно быть вообще, поэтому необходимо открыть список задвоенных урл, и устранить дубли. Подобной ошибкой часто грешат бесплатные CMS (WordPress, Joomla, Opencart, MODx), которые по умолчанию делают дубли страниц, согласно заложенной структуре разработчика.

-

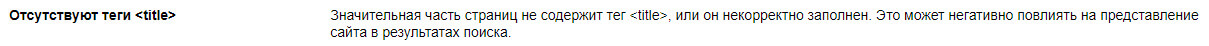

Ошибка (или отсутствие) метатега title. Проверяя страницы робот должен увидеть метатег title на каждой из них. Этот тег не должен повторяться, часто его дублируют с тегом h1. Ошибкой это не является, хотя рекомендуется делать эти теги разными.

- Ошибка (или отсутствие) метатега description. Аналогично тегу title, каждая страница должна содержать уникальный description. Стоит обратить внимание на технические страницы, если они не закрыты от индексации, то также должны иметь вышеуказанные метатеги.

Остальные рекомендации

Вебмастер.Яндекс также дает рекомендации, добавлять их или нет которые решает оптимизатор. Некоторые пункты мы настоятельно рекомендуем вносить для улучшения видимости сайта в поисковых системах.

-

Сайта нет в Яндекс.Справочнике. Если вы хотите видеть карточку компании при вводе брендового запроса – заполните все поля в справочнике и после проверки, Яндекс будет брать данные для карточки из справочника и выводить в профиле справа от выдачи.

-

Не указан регион сайта. Этот пункт можно пропустить, если активно заниматься SEO вы не планируете. Со временем Яндекс сам присвоит регион сайта, или вы можете указать его сами.

-

Отсутствует favicon сайта. Favicon это маленькая иконка сайта, находящаяся около заголовка в поисковой выдаче. Наличие фавикона повышает привлекательность сниппета, тем самым улучшая поведенческие факторы.

-

Сайт не оптимизирован под мобильные и портативные устройства. Ещё несколько лет назад Yandex и Google не обращали внимание на адаптивную версию веб-сайта, но после ввода собственных форматов APM и Turbo, они не просто стали учитывать корректность отображения на мобильных устройствах, но и понижать позиции в мобильной выдаче при проблемах адаптации сайта.

-

Ошибка счётчика Яндекс.Метрики. При анализе сайта, робот не нашел кода Яндекс.Метрики. Этот пункт можно пропустить, он не влияет на ранжирование, и необходим для получения данных конверсии и поведении пользователей на сайте

Безопасность и нарушение

Этот раздел многие оптимизаторы называют «страницей счастья», ведь именно сюда приходят оповещения при нарушении правил поисковой системы Яндекс и обнаружения вредоносного кода. В каком случае веб-сайт попадает в этот раздел?

-

На сайте велось черно SEO продвижение

-

Сайт покупал или продавал ссылки через биржу

-

Сайт получил фильтр за переоптимизацию страниц

-

После взлома или целенаправленно код сайта содержит вредоносное ПО

Яндекс дает тезисное объяснение за что сайт получил нарушение, или нарушил правила безопасности. Только в случае взлома ресурса и быстром устранении всех проблем можно избежать вылета из поисковой выдачи. Другие нарушения чреваты санкциями, на устранение которых уйдет не менее 6-8 месяцев.

В самом начале SEO-продвижения сайта специалист обязан «уведомить» поисковые системы о наличии сайта в индексе и оценить, какие проблемы отображает Яндекс или Google по своим стандартам. Сайт добавляется в Вебмастер – сервис Яндекса, в котором содержится панель инструментов для оценки качества индексации сайта. Этот инструмент находится по URL-адресу: https://webmaster.yandex.ru/. Верификация осуществляется тремя способами:

- Добавление соответствующего кода в тег «head».

- Размещение файла Вебмастера сайта в корневой папке проекта.

- Добавление TXT-записи верификации в DNS домена сайта.

Если домен новый и ни разу не проверялся Яндексом, необходимо подождать несколько дней, чтобы сформировался предварительный отчет и на панели можно было обнаружить ошибки. Их необходимо устранять в кратчайшие сроки.

В данной статье рассмотрим самые частые ошибки Вебмастера Яндекса и приведём рекомендации по их устранению.

Содержание:

- Категории проблем

- Фатальные ошибки

- Критичные ошибки

- Возможные ошибки

- Рекомендации

- Вывод

Категории проблем

Ошибки проверяемого сайта указаны в разделе «Диагностика сайта». Существует 4 категории ошибок, которые фиксирует Яндекс и сообщает об этом пользователю:

- Фатальные — отображаются возможные проблемы с подключением сайта к серверу, его корректной настройкой, доступностью для последующего индексирования, соблюдением правил безопасности и общих правил поисковой системы.

- Критичные — выдаются проблемы с настройкой SSL-сертификата (он отвечает за безопасное HTTPS-соединение, важный фактор в SEO-оптимизации), ссылками с 404-ошибкой и скоростью ответа сервера на запрос.

- Возможные — потенциальные проблемы, которые влияют на общее качество сайта для потенциальных пользователей и скорость обхода отдельных страниц сайта – правильная настройка XML-карты, наличие файла robots.txt, разрешение на обход внутренних страниц через статистику из Метрики (настройка параллельного отслеживания данных со счетчика статистики), наличие дублирующихся страниц.

- Рекомендации — общая информация для улучшения представления сайта в поиске.

Как правило, все ошибки и рекомендации важно закрывать и исправлять, а при выполнении вовремя уведомлять системы через кнопку «Проверить». Также рекомендуется отправить отредактированные страницы на переобход (раздел «Индексирование», далее – «Переобход страниц»).

Рассмотрим подробнее все варианты и пути для исправления.

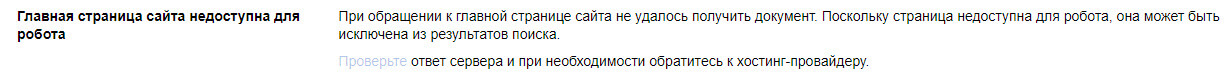

Фатальные ошибки

Уведомления о наличии такого рода проблем могут появляться в следующих ситуациях:

«Главная страница возвращает ошибку»

Проблема отображается, если главная страница не выдает корректный ответ сервера — «200 ОК», это можно проверить в разделе «Инструменты» — «Проверка ответа сервера». Причины могут быть разные — страница закрыта от индексации, произошел сбой в настройке сервера, главная страница перенаправлена на другую страницу (для нее настроен редирект).

Для исправления необходимо проверить файл robots.txt на наличие правила «Disallow» для главной страницы или убрать тег noindex в метатеге robots в коде главной страницы.

«Не удалось подключиться к серверу из-за ошибки DNS»

Это означает, что при индексировании поисковый робот не смог получить IP-адрес сервера, на котором расположены файлы сайта. Адрес присваивается хостинг-провайдером и указывается в панели управления DNS-записями. При корректной настройке ответ сервера для ресурса – «200 ОК». В случае неполадки следует обращаться к хостинг-провайдеру.

«Сайт закрыт от индексирования в файле robots.txt»

Зачастую такая ошибка возникает после переноса готового проекта с тестового домена (откуда велась разработка) на основной. В файле robots.txt обычно в таких случаях прописывается правило «Disallow: /», означающая закрытие от индексации абсолютно всех страниц сайта. Чтобы устранить эту ошибку, требуется просто удалить эту строку из файла для всех элементов User-Agent.

«Обнаружены нарушения или проблемы с безопасностью»

В эту категорию фатальных проблем попадают сайты, замеченные за нарушениями, которые противоречат правилам поисковиков, среди таких нарушений могут быть:

- переспамленные SEO-тексты;

- обман Яндекса с целью манипуляции выдачей в топе поиска;

- чрезмерная закупка SEO-ссылок — наличие большого количества внешних ссылок, закупленных в течение недавнего времени;

- дорвеи — наличие сквозного веб-ресурса, который за счет мощного трафика перенаправляет пользователей на продвигаемый сайт;

- майнинг

- малополезный контент;

- фишинг — сбор конфиденциальной информации, логинов, паролей, данных для связи

- «черные» и «серые» методы продвижения, связанные с манипуляцией поведенческими факторами или большим количеством автоматических переходов (накрутка ботами), применяемая не только некоторыми SEO-оптимизаторами, но и недобросовестными конкурентами.

Чтобы узнать точный ответ, что именно исправлять, необходимо перейти в раздел «Безопасность и нарушения» и нажать на кнопку с вопросительным знаком. Далее от SEO-шника требуется внимательно исправить ошибку, чтобы после устранения проблемы в том же разделе нажать кнопку «Я всё исправил». Проблем должна исчезнуть, в противном случае придется ждать минимум 3 месяца.

Критичные ошибки

Рассматриваемые проблемы могут стать причиной понижения позиций по продвигаемым запросам по отдельным страницам или для всего сайта.

«Долгий ответ сервера»

В данном случае страницы долго отвечают на запросы поискового робота. Для проверки скорости прямо в Вебмастере можно использовать инструмент «Проверка ответа сервера». Оптимальное время для корректной работы — не более 3-х секунд. В противном случае необходимо настроить кэширование ресурса, устранить ошибки и добавить ресурс на хостинге, а также сократить число запросов к базе данных.

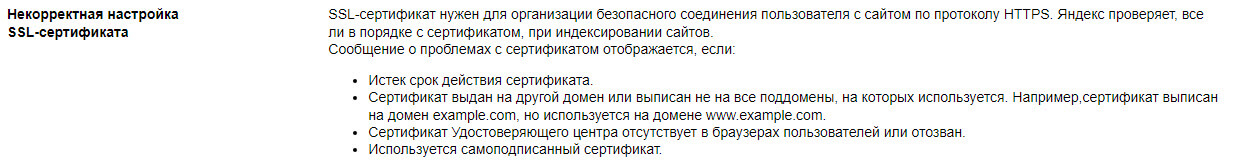

«Некорректная настройка SSL-сертификата»

Для безопасного соединения ресурса с пользователем с возможностью предоставления информации используется SSL-сертификат, обеспечивающий защищенное HTTPS-соединение. Критическая проблема может появиться в следующих случаях:

- Истек срок действия — требуется продление;

- Сертификат был аннулирован по причине проблем в удостоверяющем центре — заменить на корректный и работающий на всех популярных браузерах;

- Сертификат оформлен на дублирующийся домен — заменить на актуальный адрес и заодно настроить перенаправление;

- Использование самописного SSL — заменить на один из популярных и работающих.

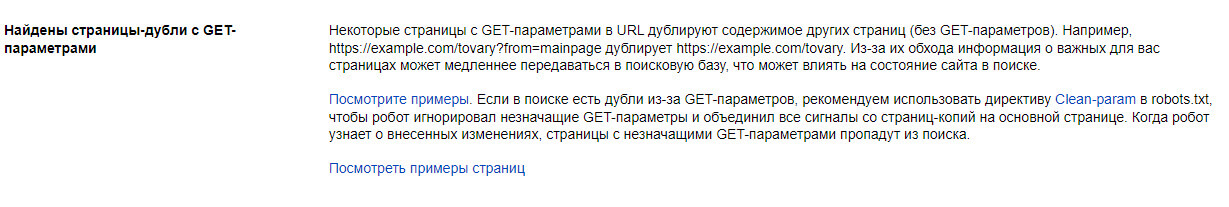

«Найдены страницы-дубли с GET-параметрами»

К проблеме относятся дубли страницы с одинаковым содержимым, но доступные по разным URL-адресам. Это или страницы без перенаправления на правильный адрес или содержащие GET-параметр, связанный с динамической ссылкой для сервера.

Для исправления необходимо добавить правило «Clean-param:» в файл robots.txt или разместить в теге «head» атрибут rel=”canonical” с отображением правильной версии страницы. Проблема «уходит» автоматически через несколько дней.

Возможные ошибки

Самый распространенный вид, к которым относятся небольшие проблемы при SEO-оптимизации.

«Не найден файл robots.txt»

Данный файл нужен для определения правил индексирования для поисковых роботов, что можно включать в выдачу, а что — нельзя. Иногда бывает, что Вебмастер может случайно сообщить об ошибке, даже если файл размещен в корневой системе сайта. В таком случае нужно нажать кнопку «Проверить» и в течение 2-3 дней уведомление удалится.

«Обнаружены ошибки в файле robots.txt»

Необходимо через Вебмастер проверить на наличие ошибок файл robots.txt, который закрывает часть страниц от индексирования. Для исправления требуется еще раз проверить документ на правильную настройку директив.

«Нет используемых роботом файлов Sitemap»

Sitemap.xml представляет собой список всех страниц сайта, который считывает поисковая система, загружая в свою базу новые страницы. Для устранения проблемы нужно создать и загрузить на сервере файл (через специальные сервисы, например SiteAnalyzer, а также стандартный SEO-плагин в CMS), указать в панели Вебмастера ссылку на карту («Индексирование» — «Файлы Sitemap»), а также скопировать путь к файлу и отметить в файле robots.txt.

«Обнаружены ошибки в Sitemap»

В Вебмастере есть компонент «Анализ файлов Sitemap», с помощью которого можно проверить все строки файла на ошибки и устранить их. Вносить изменения рекомендуется, даже несмотря на то, что при наличии проблем поисковая система не блокирует весь файл, а игнорирует незнакомые инструкции.

«Отсутствуют элемент title и метатег description»

Теги title и description необходимы для соответствия ресурса запросу пользователя. С их помощью поисковая систем формирует сниппет — краткое описание сайта в выдаче. Метатеги обязательны к заполнению.

«На страницах имеются одинаковые заголовки и описания»

Метатеги title и description должны быть не только заполнены, но и различимы между собой. Рекомендация исчезнет после изменений и последующей проверки роботом, рекомендуется указать ссылки на измененные страницы в разделе для переобхода.

«Файл favicon недоступен для робота»

![]()

В данном случае иконка не всегда показывается в результатах поиска (в зависимости от браузера). Посмотрите причину: ответ сервера не «200 ОК» — проверьте ссылку, причина может быть в неправильном значении данных в параметре type.

Рекомендации

В этой категории отображаются предложения по улучшению позиций сайта.

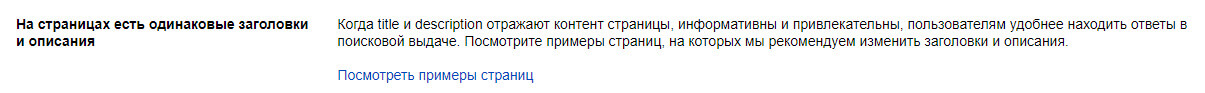

«В результатах поиска найдены поддомены»

Если в проекте имеются региональные поддомены, их также нужно добавлять в Вебмастер в качестве отдельных ресурсов, а в разделе «Региональность» присвоить геопривязку через карточку компании в Яндекс.Бизнес и добавление ссылки на страницу «Контакты», где указан фактический адрес. Для поддоменов дополнительная верификация не требуется – достаточно просто добавить проект на уже подтвержденный аккаунт для основного зеркала сайта.

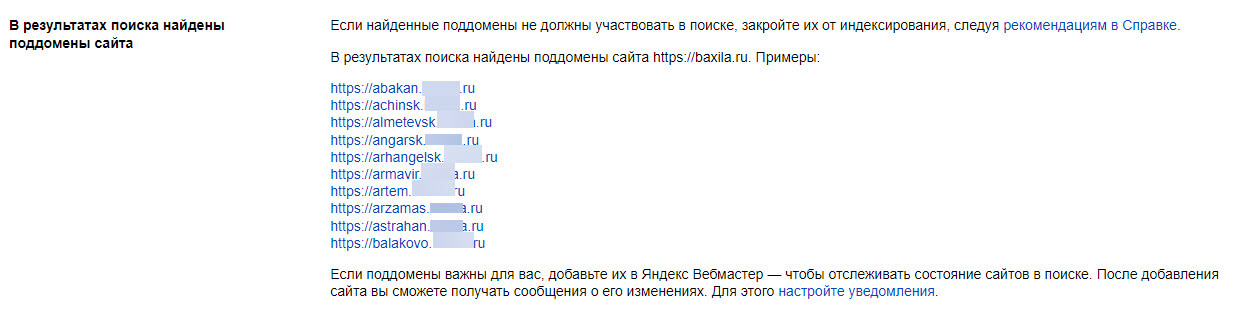

«Не задана региональная принадлежность сайта»

В блоке «Региональность» нужно указать регион (город или субъект), чтобы лучше отображать продвигаемый сайт по геозависимым запросам, когда пользователь ищет товар или услугу, не указывая регион в поисковой строке, а находясь в нем.

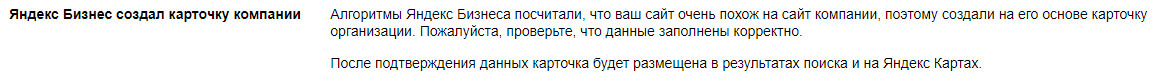

«В Бизнесе подготовлена карточка организации»

Сервис «Яндекс.Бизнес», с помощью которого можно создавать карточки компании для отображения, например, в картах, может автоматически сформировать профиль на основе контента, особенно это относится к новым сайтам. В данном случае необходимо проверить и подтвердить содержимое карточки.

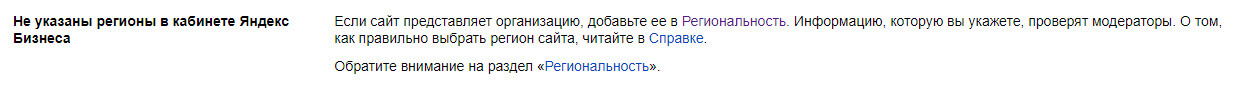

«Не указаны регионы в Яндекс Бизнесе»

Проблема относится к профилю в «Яндекс.Бизнесе». Необходимо выполнить все условия для правильного отображения карточки:

- данные заполнены на 90% и более (получена специальная «галочка» о том, что владелец компании подтвердил все указанные данные);

- указано главное зеркало сайта;

- с момента создания карточки прошло больше 1 недели.

Если все условия выполнены, рекомендация пропадет из раздела диагностики.

«Файл favicon не найден»

![]()

В качестве рекомендации может выпасть не только отсутствие favicon, но и его правильный формат – с расширением «.svg» или размером от 120х120 пикселей.

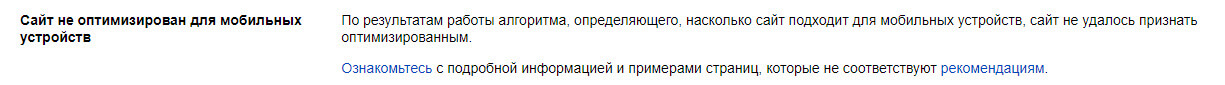

«Сайт не оптимизирован для мобильных устройств»

Чтобы увидеть замечания, необходимо перейти в раздел «Инструменты» — «Проверка мобильных страниц» и ознакомиться с рекомендациями от Яндекса, которые мешают корректному отображению мобильной версии сайта. Если все изменения были сделаны или ошибок не обнаружено, можно нажать кнопку «Проверить» для дополнительного анализа со стороны робота.

Вывод

При обнаружении ошибок в Яндекс.Вебмастере особое внимание уделите фатальным и критическим ошибкам – они напрямую влияют на работоспособность сайта и могут обрушить позиции сайта по продвигаемым запросам на несколько страниц вниз. Для устранения ошибок желательно привлекать технического специалиста (программиста или разработчика). Возможные проблемы относятся больше к компетенции SEO-специалистов и требуют чуть больше времени на исправления — все зависит от размера сайта.

К рекомендациям также следует присматриваться, чтобы успешно конкурировать с сайтами в топе поиска и улучшать коммерческие и поведенческие факторы.

Время чтения — 2 минуты

Ошибки Я.Вебмастера. Сайт заблокирован для индексации в robots.txt

20.02.2020

- →

- →

Вебмастер Яндекс – эффективный инструмент, позволяющий отслеживать и устранять различного рода фатальные ошибки (включая закрытие сайта для индексации), которые были выявлены в процессе диагностики. Возврат кода ошибки главной страницы, отсутствие подключения к DNS-серверу, нарушение уровней безопасности – это лишь самый незначительный перечень фатальных проблем, диагностируемых Я.Вебмастером. Отдельного внимания заслуживает ошибка, связанная с запретом индексации сайта в файле robots.txt.

София Воробьёва

Специалист по SEO-продвижению

Как проверить, открыт ли сайт для индексации в файле robots.txt?

Чтобы узнать, есть ли запрет индексации на вашем сайте, добавьте в браузере к URL вашего сайта /robots.txt, чтобы получилось yoursite.ru/robots.txt.

Корректность составления индексного файла (наличие грубых ошибок) можно проверить с помощью соответствующих бесплатных инструментов в вебмастерах Яндекс и Google.

Полный запрет индексации задается правилами:

Disallow: *

или

Allow:

Какие действия предпринять, если Вебмастер показывает ошибку

Проверьте файл robots.txt на предмет наличия ошибок инструментом Вебмастера «Анализ robots.txt»

Результатом сканирования файла могут быть:

- предупреждения, которые свидетельствуют о потенциальных проблемах и могут быть исправлены Я.Вебмастером в автоматическом режиме;

- фатальные ошибки в синтаксисе файла. Данное указывает, что в силу проблем, допущенных при формировании правил и директив robots.txt, инструмент не может считать строковое значение или даже целый текстовый блок.

- файл robots.txt может быть также закрыт от индексации ввиду некорректной регистрации домена или отсутствием ее, как таковой.

Чтобы полностью открыть сайт для индексации

Пропишите в файле robots.txt правило:

Отсутствие систематического контроля за изменением robots.txt, а также регулярного мониторинга результатов сканирования файла на предмет предупреждений и фатальных ошибок, может привести к нарушению алгоритмов навигации поисковых роботов и блокировке сайта от индексации поисковыми системами.

Читайте также

— Заказать консультацию

С сентября 2017 года резко выросло количество оповещений в панели Вебмастера Яндекс о фатальной ошибке, причём часто под санкции попадают сайты, которым под фильтром по теории поискового заговора делать нечего. Что это за… откуда деньги у атамана и как избавиться от фильтра? Начнём с погружения в глубину проблемы:

Обнаружены нарушения или проблемы с безопасностью

Первопричина санкций

За последние года Платон Щукин и К не раз устраивал веб-мастерам Варфоломеевскую ночь. Начиналось всё с борьбы со ссылками и со временем переросло в нечто больше, требующее погружения в основы бизнеса.

Яндекс компания коммерческая и акционеры желают в лучшем случае получать прибыль, в худшем видеть нововведения со стороны руководства. Лучший случай тесно переплёлся с худшим, и под флагом борьбы за качество поисковой выдачи Yandex начал забирать 80% прибыли от создателей сайтов. Так как коммерческие проекты более богаты, то начали с них, убедительно объяснив без применения насилия, что благо для бизнеса – это Директ.

Ссылки на 90% ушли в небытие, коммерция низко наклонив голову ушла в Директ и наступило время информационных сайтов. Увести их в контекстную рекламу массово не получится, но дырки в бюджете надо закрыть, если не прибылью, то активностью (читать выше). Массовое появление в панели фатальной ошибки говорит о чистке поисковой выдачи. Какая тут прибыль? Всё просто – режутся сайты с небольшой и средней посещаемостью, им на смену приходят ущербные порталы типа fb.ru, которые сами едят со стола Директа и его кормят.

Формальная причина фатальной ошибки

Алгоритмы ранжирования Яши учитывают тысячи различных факторов, поэтому всегда найдётся таракан за дверью, которого владелец сайта не успел пришибить шлёпанцем. Боты снуют по сайтам и, если у ресурса нет крыши в виде большой посещаемости и рекламы Директа, то ресурс получает фатальную ошибку.

Помните «был бы человек, а статья найдётся»? Яндекс использует присказку на 100%, добавив в неё только выверт «чужой человек».

Итак, появляется фатальная ошибка в 90% случае из-за:

- Рекламы Google в первом окне,

- Большого % страниц с малым объёмом информации,

- Жизненной кармы веб-мастера,

- Просто так.

Если увидели в панели:

Позиции сайта в результатах поиска понижены

То грустный клоун пришёл и на вашу улицу.

Признаки санкций – падение трафика на 40-80% и откат позиций на 20-30 мест в глубины выдачи.

Лечимся

Тяжело лечиться, если врач на лету придумал тебе диагноз, но жизнь требует биения сердца, поэтому надо пытаться избавиться от фатальности Яши. Вот перечень действий, которые могут прийти на помощь при санкциях:

- Съём рекламы с первого экрана,

- Удаление или disallow страниц небольшого объёма (малополезных),

- Форматирование больших, но портяночных страниц,

- Здоровый сон.

В 2 случаях из 5 ошибка пропадает при переотправке сайта на проверку без каких-либо телодвижений. Ещё в одном случае помогает съём рекламы. На конец октября 2017 не могу сказать, что поможет в 2 оставшихся случаях, возможно, Яндекс сам поймёт, что если так рубить лес, то жить скоро придётся среди пней и откатит санкции, вернув веб-мастеру надежду.

Также советую не печалиться при фатальной ошибке, ведь жизнь много шире, чем потеря трети трафика и клейма санкционщика на лбу.